Data Quality Management

Mit intelligenten Algorithmen

Data Quality Management (auch bekannt als Datenqualitätsmanagement) ist ein Betriebsprozess zur kontinuierlichen Überwachung und Optimierung der Qualität geschäftskritischer Daten. In der digitalen Welt ist ein Data Quality Management unverzichtbarer Bestandteil einer Data Lake Architektur. Denn sämtliche Anwendungsbereiche zur Datennutzung, wie beispielsweise Machine Learning, Business Intelligence, Customer Relationship Management (CRM), Supply Chain Management (SCM) oder Enterprise Resource Planning (ERP) benötigen verlässliche Daten, um wertschöpfende Ergebnisse erzeugen zu können.

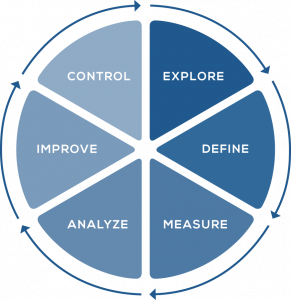

Unsere Machine Learning Algorithmen bringt Sie in Kombination mit unserem vielfach eingesetzten IQI® Data Quality Management Zyklus auf die Überholspur. Dadurch sichern Sie zügig und dauerhaft Ihre Datenqualität und können so mit dem Wettbewerb mithalten. Wir führen die dafür notwendigen Standards, Prozesse und Automatismen bei Ihnen ein, damit Sie ohne großen Aufwand ein hohes Datenqualitätsniveau erreichen.